MICROSERVIZI: COSA SONO, CARATTERISTICHE E VANTAGGI

Cosa sono i Microservizi?

I microservizi sono un approccio allo sviluppo dell’architettura software emerso in particolar modo per sviluppare le applicazioni moderne di tipo Cloud-based. Con questo modello, le applicazioni vengono scomposte in “piccoli” servizi (microservizi, come suggerisce il nome) autonomi ed indipendenti tra loro che comunicano tramite API ben definite, con l’obiettivo di semplificare il processo di deployment e fornire software di alta qualità in tempi rapidi. I microservizi, infatti, permettono di scalare in modo più semplice e soprattutto più veloce, promuovendo l’innovazione e accelerando lo sviluppo di nuove funzionalità.

Architettura monolitica vs microservizi

I microservizi si contrappongono alla tradizionale architettura monolitica usata per sviluppare le applicazioni, la quale prevede che ogni componente venga creato all’interno dello stesso elemento. Il metodo monolitico, però, ha alcuni svantaggi. Maggiori sono le dimensioni dell’applicazione, più complicato sarà risolvere rapidamente i problemi ed implementare nuove features. Con questo approccio infatti, tutti i processi sono collegati tra loro e vengono eseguiti come un unico servizio. Questo significa che quando un processo sperimenta un picco nella richiesta, è necessario ridimensionare l’intera architettura. Di conseguenza aggiungere o modificare una funzionalità diventa molto laborioso, limitando la sperimentazione e l’inserimento di nuove features.

Allo stesso tempo, con le architetture tradizionali si amplia il rischio relativo alla disponibilità dell’applicazione, in quanto la presenza di processi strettamente connessi e dipendenti uno dall’altro aumenta l’impatto di un errore in un singolo processo.

L’approccio che utilizza i microservizi semplifica la risoluzione delle problematiche e ottimizza i tempi di sviluppo. Ciascun processo o componente costituisce un microservizio e viene eseguito come un servizio indipendente. I microservizi comunicano tra di loro utilizzando un’interfaccia formata da API “leggere” ed interagiscono per completare le stesse attività pur rimanendo indipendenti uno dall’altro, con la possibilità di condividere processi simili tra più applicazioni. E’ un modello altamente granulare in cui ogni microservizio corrisponde ad una funzione aziendale ed esegue solo una funzione. Inoltre, l’indipendenza tra i servizi elimina i problemi relativi all’aggiornamento, al ridimensionamento e alla distribuzione tipiche di un’architettura monolitica.

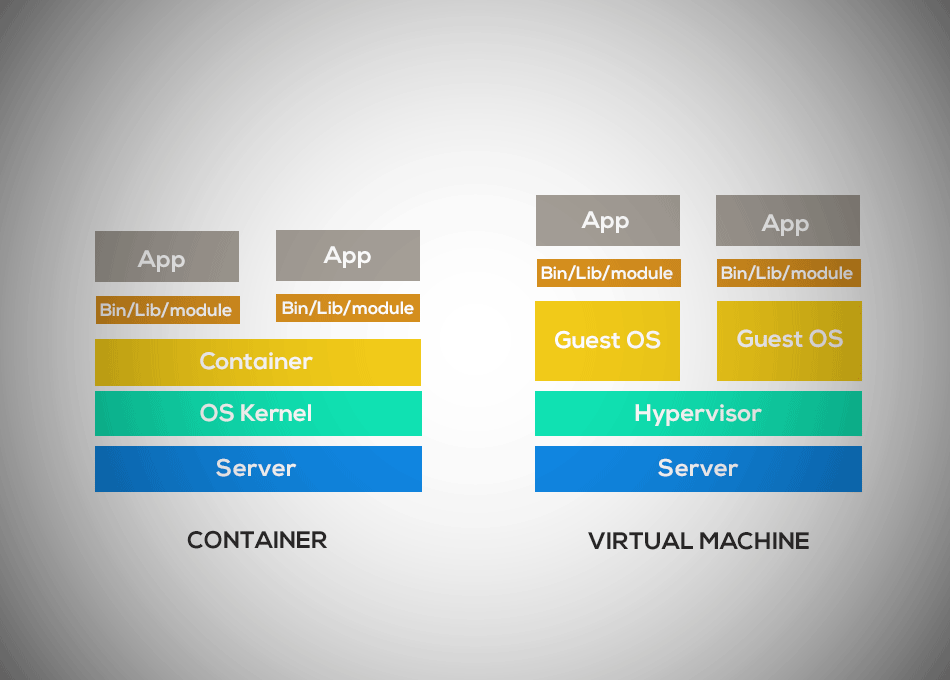

Microservizi e container

Sebbene l’architettura basata sui microservizi non sia del tutto nuova, la presenza dei container ha reso molto più semplice adottarla. I container rappresentano l’ambiente di sviluppo ideale per le applicazioni che usano i microservizi perchè consentono di eseguire diverse parti di un’applicazione in modo indipendente, sullo stesso hardware e operando un controllo superiore sui cicli di vita del software. I container forniscono ai microservizi un ambiente autosuffciente in cui la gestione di servizi, storage, rete e sicurezza diventa più semplice. Proprio per queste ragioni, microservizi e container insieme costituiscono la base dello sviluppo di applicazioni Cloud-native. Inserendo i microservizi nei container si accellera lo sviluppo e si facilita la trasformazione e l’ottimizzazione delle app esistenti.

I vantaggi dell’approccio basato sui microservizi

I microservizi, quando sono implementati correttamente, consentono di migliorare l’affidabilità e la scalabilità delle applicazioni. Come accennato poco fa, uno degli aspetti più interessanti dei microservizi nei confronti delle architetture monolitiche, è che un difetto o un bug in un singolo servizio non va ad influenzare il funzionamento degli altri servizi, pertanto non compromette l’intera applicazione. Questi e molti altri sono i vantaggi dei microservizi: vediamoli insieme.

- Eliminazione dei single point of failure

- Elevata scalabilità e resilienza

- Time-to-market

- Deployment semplificato

- Top performance

- Libertà nell’uso delle tecnologie

- Maggiore sperimentazione ed innovazione

- Codice riutilizzabile

- Flessibilità del linguaggio di sviluppo

- Sistema più agile

…e gli svantaggi

Non dimentichiamo però che i microservizi, sebbene rappresentino un modello di sviluppo innovativo e molto performante, hanno anche i loro svantaggi. Tra questi la complessità che si associa tipicamente a tutti i sistemi distribuiti, la necessità di utlizzare metodi di testing molto solidi e di avere a disposizione personale esperto per la gestione dei processi e l’assistenza tecnica. Inoltre, se un’applicazione non ha necessità di scalare rapidamente o non è Cloud-based, i microservizi potrebbero fornire benefici poco significativi all’architettura di sviluppo.