KUBIFY: UN NUOVO MODO DI FARE HOSTING

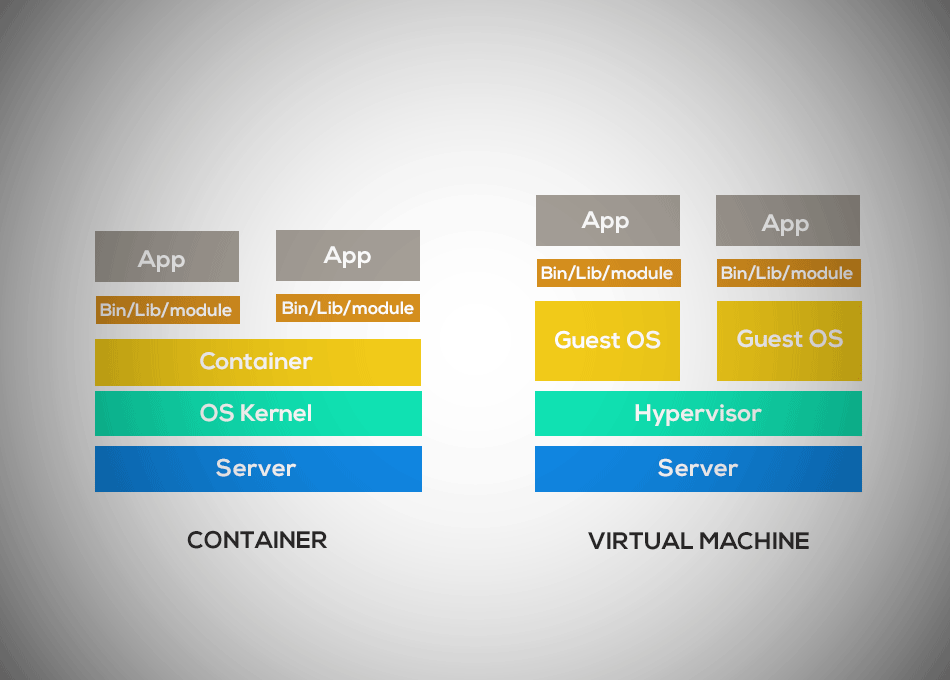

Kubify è una soluzione di hosting innovativa, gestita tramite Container Kubernetes. Rispetto ad una soluzione di virtualizzazione tradizionale, i container garantiscono la massima disponibilità del servizio, consentono di raggiungere performance elevate e forniscono numerosi vantaggi alle aziende che li utilizzano.

Cos’è Kubify?

Kubify è una soluzione di hosting PaaS (Platform as a Service) Multidatacenter e ibrida, che utilizza l’efficienza dello storage Azure e la potenza di calcolo e la scalabilità dei nostri Datacenter per assicurare la massima affidabilità e sicurezza. Una delle caratteristiche che differenzia Kubify da tutti gli altri prodotti sul mercato è che si tratta di un servizio “chiavi in mano” completamente gestito: i clienti non dovranno più occuparsi dell’infrastruttura dal punto di vista tecnico, ma avranno a disposizione una piattaforma “tutto incluso” su cui sviluppare le proprie applicazioni in maniera semplice e performante.

I vantaggi di Kubify

Oltre ai vantaggi derivanti dall’utilizzo dei container, il nostro servizio di hosting PaaS Kubify include una serie di servizi aggiuntivi che garantiscono ai business la massima produttività.

- Ambienti GIT, sviluppo e testing gratuiti: la nostra soluzione include la fornitura di un ambiente GIT, oltre alla possibilità di attivare ambienti gratuiti di sviluppo e testing per verificare il proprio progetto. Questa feature consente di effettuare il deploy delle applicazioni in maniera semplice e totalmente automatizzata.

- Servizio di back-up: Kubify comprende un servizio di back-up con frequenza oraria per garantire ai clienti la più totale sicurezza di dati e processi aziendali. Le soluzioni di back-up sono completamente personalizzabili sulle esigenze di ogni singolo business.

- Syntehetic Monitoring: mettiamo a disposizione dei nostri clienti uno strumento di Synthetic Monitoring con l’obiettivo di verificare le performance del sito web navigandolo con browser reali da varie regioni d’Italia. Il servizio di synthetic monitoring genera insight fondamentali per migliorare le prestazioni web e fornire agli utenti esperienze di navigazione di alto livello.

- Supporto H24 e SLA 99,99%: Kubify assicura la massima affidabilità del servizio anche in caso di picchi di traffico, con uno SLA pari al 99,99%. Inoltre il nostro team di specialisti è disponibile h24 per risolvere possibili problematiche e garantire l’uptime del sito.

- Log dashboard e security control: per garantire la massima sicurezza del sistema forniamo un servizio di Security Control che permette di monitorare efficacemente i propri container. Mettiamo a disposizione del cliente una dashboard per l’archiviazione e la consultazione dei log, tramite la quale è possibile individuare eventuali attacchi informatici e agire tempestivamente.

- Soluzioni CDN: Kubify include soluzioni di Content Delivery Network di alto livello, studiate per adattarsi istantaneamente alle condizioni di Internet e ottimizzare la User Experience dei clienti con performance e sicurezza senza precedenti. Vuoi migliorare le prestazioni web? Le soluzioni CDN sono ciò che fa per te: accellera il tuo sito, aumenta le revenue e fai crescere il tuo business a livello globale.

Sei interessato alla soluzione Kubify hosting PaaS? Prenota subito una consulenza gratuita!

Contattaci

Compila il form e un nostro esperto ti ricontatterà entro 24 ore: non vediamo l’ora di conoscerti!